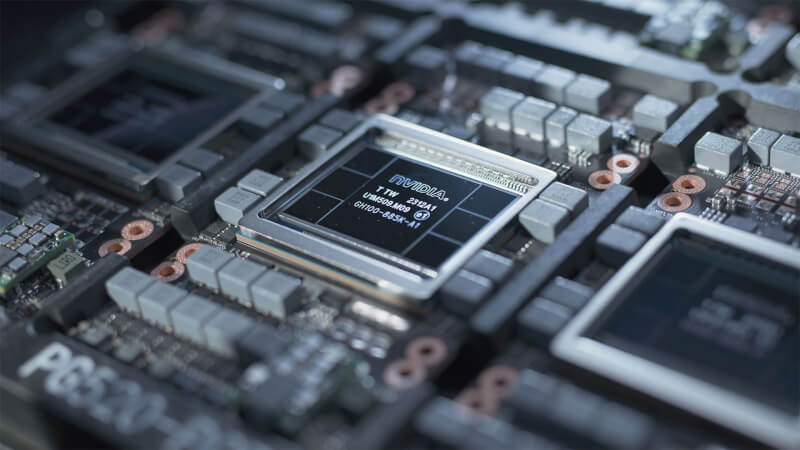

Musk: Grok 3 kræver 100.000 NVIDIA H100 AI GPUs

Elon Musk, administrerende direktør for Tesla og grundlægger af xAI, kom med nogle dristige forudsigelser om udviklingen af kunstig generel intelligens (AGI) og diskuterede udfordringerne, som AI-industrien står overfor. Han forudsiger, at AGI kan overgå menneskelig intelligens allerede næste år eller inden 2026, men at det vil kræve et ekstremt antal processorer at træne, hvilket igen kræver enorme mængder elektricitet, rapporterer Reuters.

Musks projekt, xAI, træner i øjeblikket den anden version af sin Grok store sprogmodel og forventer at afslutte sin næste træningsfase i maj. Træningen af Groks version 2-model krævede så mange som 20.000 Nvidia H100 GPU'er, og Musk forventer, at fremtidige iterationer vil kræve endnu større ressourcer, hvor Grok 3-modellen skal bruge omkring 100.000 Nvidia H100 chips til træning.

Fremskridtene inden for AI-teknologi, ifølge Musk, bliver i øjeblikket hæmmet af to hovedfaktorer: mangel på avancerede processorer, som Nvidias H100, da det ikke er nemt at få 100.000 af dem hurtigt, og tilgængeligheden af elektricitet.

Nvidias H100 GPU forbruger omkring 700W, når den er fuldt udnyttet, og dermed kan 100.000 GPU'er til AI- og HPC-opgaver forbruge op til 70 megawatt strøm. Da disse GPU'er har brug for servere og køling for at fungere, er det sikkert at sige, at et datacenter med 100.000 Nvidia H100 processorer vil forbruge omkring 100 megawatt strøm. Det svarer til strømforbruget i en lille by.

Musk understregede, at selvom udbuddet af compute-GPU'er hidtil har været en betydelig hindring, vil forsyningen af elektricitet blive stadigt mere kritisk i det næste år eller to. Denne dobbelte begrænsning understreger udfordringerne ved at skalere AI-teknologier for at imødekomme de voksende beregningsmæssige krav.

Trods udfordringerne vil fremskridt inden for compute- og hukommelsesarkitekturer muliggøre træningen af stadig større store sprogmodeller (LLM'er) i de kommende år. Nvidia afslørede sin Blackwell B200 på GTC 2024, en GPU-arkitektur og platform, der er designet til at skalere til LLM'er med billioner af parametre. Dette vil spille en afgørende rolle i udviklingen af AGI.

Seneste software

-

29 aprsoftware

-

28 aprsoftware

Llama 3 kodningsydelse testet

-

Se de nyeste features i Unreal Engine 5.4

-

27 aprsoftware

Chatbots svar er opfundet: Ny værktøj hjælper dig

-

26 aprsoftware

UK overvåger Microsoft og Amazons AI-partnerskaber

-

26 aprsoftware

Apple udgiver 8 nye åbne AI-modeller med OpenELM

-

26 aprsoftware

Meta øger infrastrukturinvesteringer i AI

-

26 aprsoftware

Synthesia lancerer 'Ekspressive Avatars'